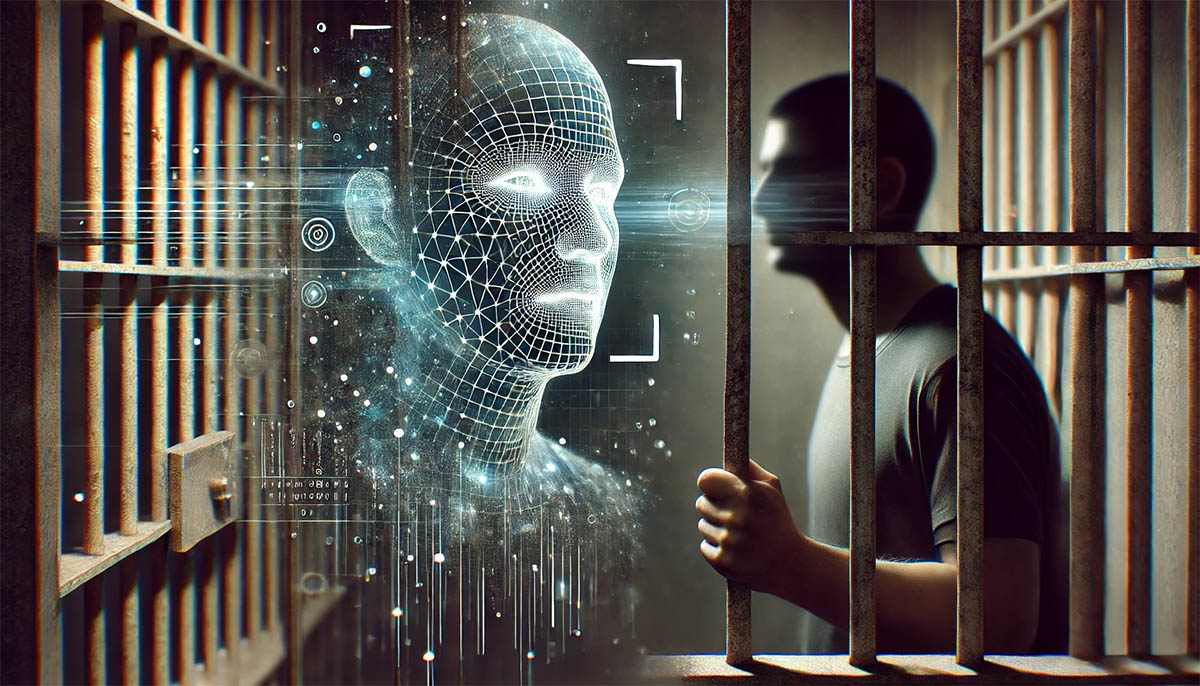

Christopher Gatlin: cómo un algoritmo de IA arruinó la vida de una persona inocente

La policía confió ciegamente en la tecnología y esto es lo que resultó.

El programa de reconocimiento facial utilizado por la policía de San Luis (Misuri, EE. UU.) llevó al arresto erróneo de Christopher Gatlin, de 29 años. Fue detenido bajo sospecha de agredir a un guardia de seguridad en la plataforma de una estación de metro, a pesar de la falta de pruebas directas. La prueba clave fue una imagen de baja calidad de una cámara de vigilancia, procesada por un programa basado en IA.

La policía ignoró sus propias directrices, según las cuales los datos del sistema no pueden ser la única base para tomar decisiones. El investigador Matthew Schut utilizó el programa para la identificación y consiguió el arresto de Gatlin. El hombre pasó más de 16 meses en prisión antes de que el tribunal declarara inválida la identificación. Este caso se convirtió en uno de los ocho conocidos en los que el uso del reconocimiento facial llevó a arrestos erróneos.

Una investigación de The Washington Post reveló que muchas dependencias policiales en los EE. UU. utilizan tecnologías de reconocimiento facial sin una verificación adecuada de los resultados. En 15 de los 23 casos analizados, los arrestos se llevaron a cabo únicamente basándose en IA, sin recopilar pruebas adicionales. En algunos casos, la policía incluso ignoró pruebas directas, como ADN o coartadas de los sospechosos.

El software suele demostrar prejuicios raciales, identificando erróneamente a personas negras y asiáticas 100 veces más que a hombres blancos. Los errores en el procesamiento de datos y la confianza infundada en los resultados de la tecnología ponen en peligro los derechos de los ciudadanos.

Los críticos destacan que el uso de estos sistemas sin el debido control conduce a un aumento en el número de acusaciones injustas. A pesar de las quejas, las dependencias policiales rara vez revelan cómo aplican las tecnologías y evitan proporcionar datos detallados.

Christopher Gatlin logró obtener su liberación gracias a un abogado que demostró que las pruebas en su contra eran poco fiables. Sin embargo, este caso reveló importantes lagunas en la regulación del uso de la IA en las fuerzas del orden y requiere una revisión de las prácticas en su aplicación.