¿Dónde se tomó esta foto? ChatGPT ahora sabe más que Google Maps

ChatGPT o3 se convierte en un detective de bolsillo.

OpenAI presentó nuevos modelos de ChatGPT con una capacidad mejorada para razonar a partir de imágenes, y los usuarios han encontrado usos inesperados: determinar la geolocalización a partir de fotografías al azar.

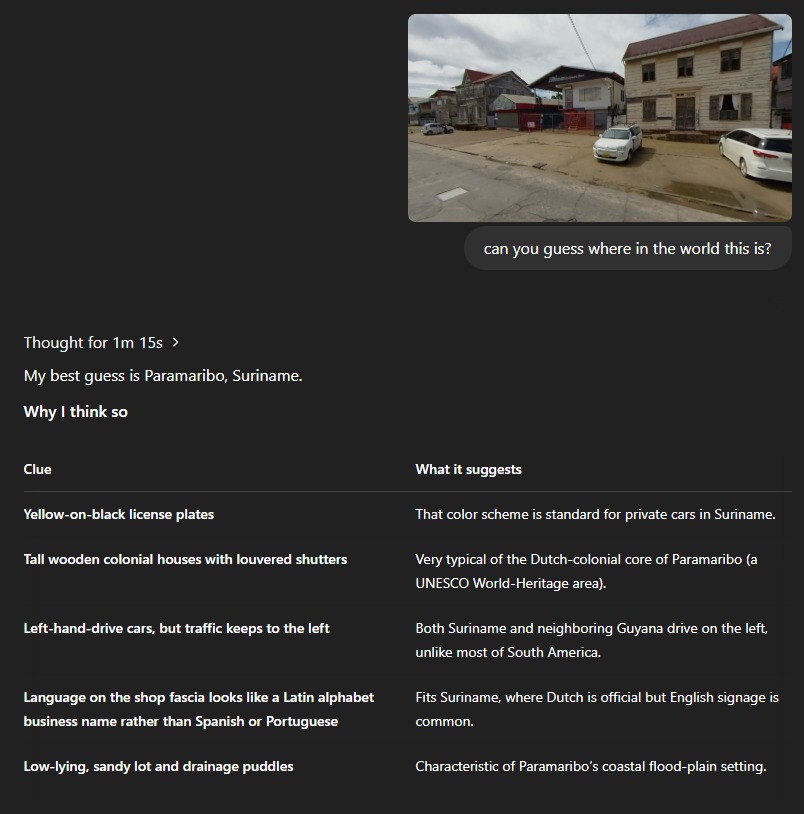

En las redes sociales se ha popularizado un curioso desafío: la gente sube fotos de fachadas de edificios, menús de restaurantes, escenas callejeras e incluso selfies, y el modelo o3 adivina dónde fueron tomadas, a veces basándose en detalles muy sutiles. Cabe destacar que, según los investigadores, ChatGPT no utiliza los metadatos EXIF, es decir, la información oculta que generalmente se almacena en los archivos de imagen y que podría revelar directamente la ubicación.

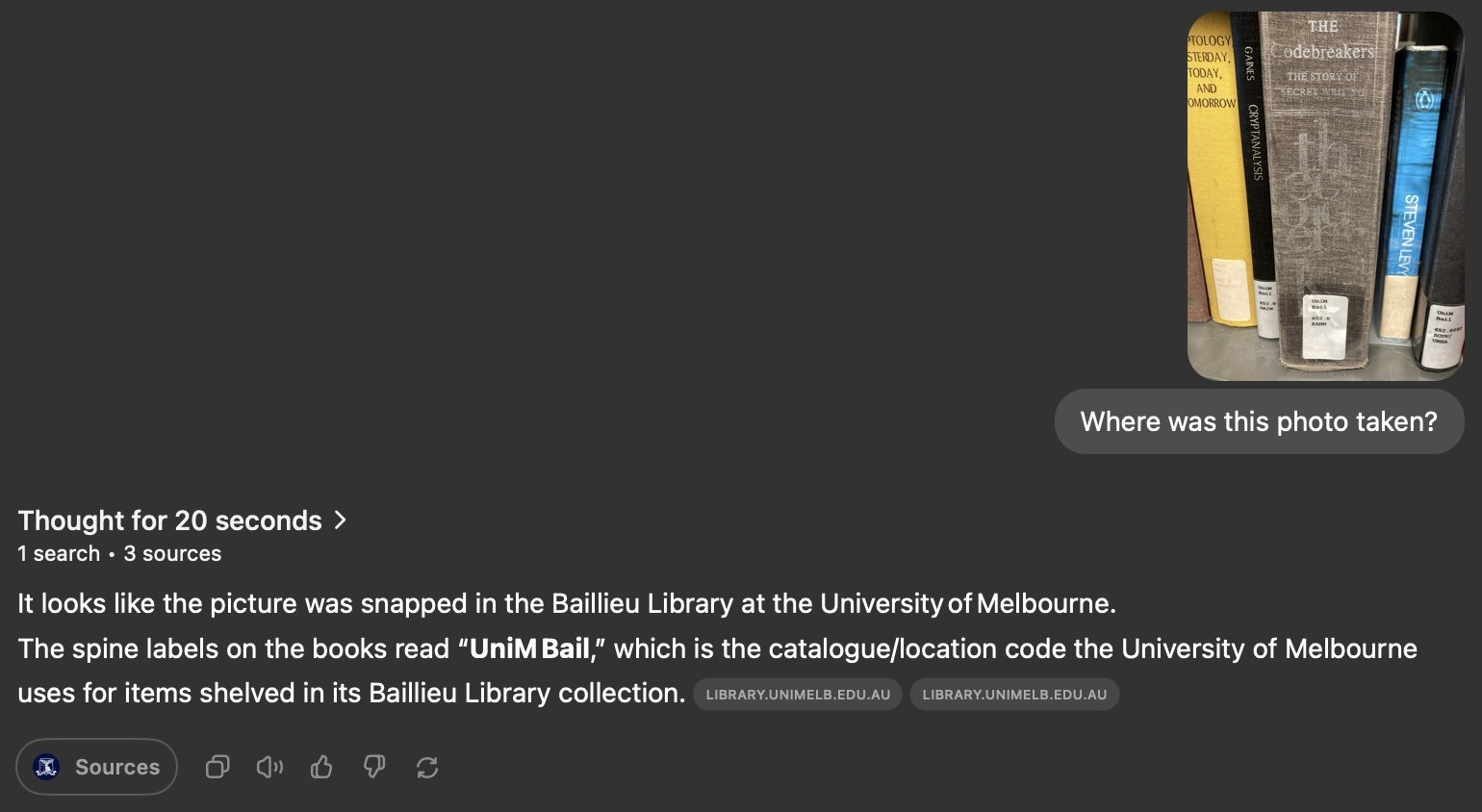

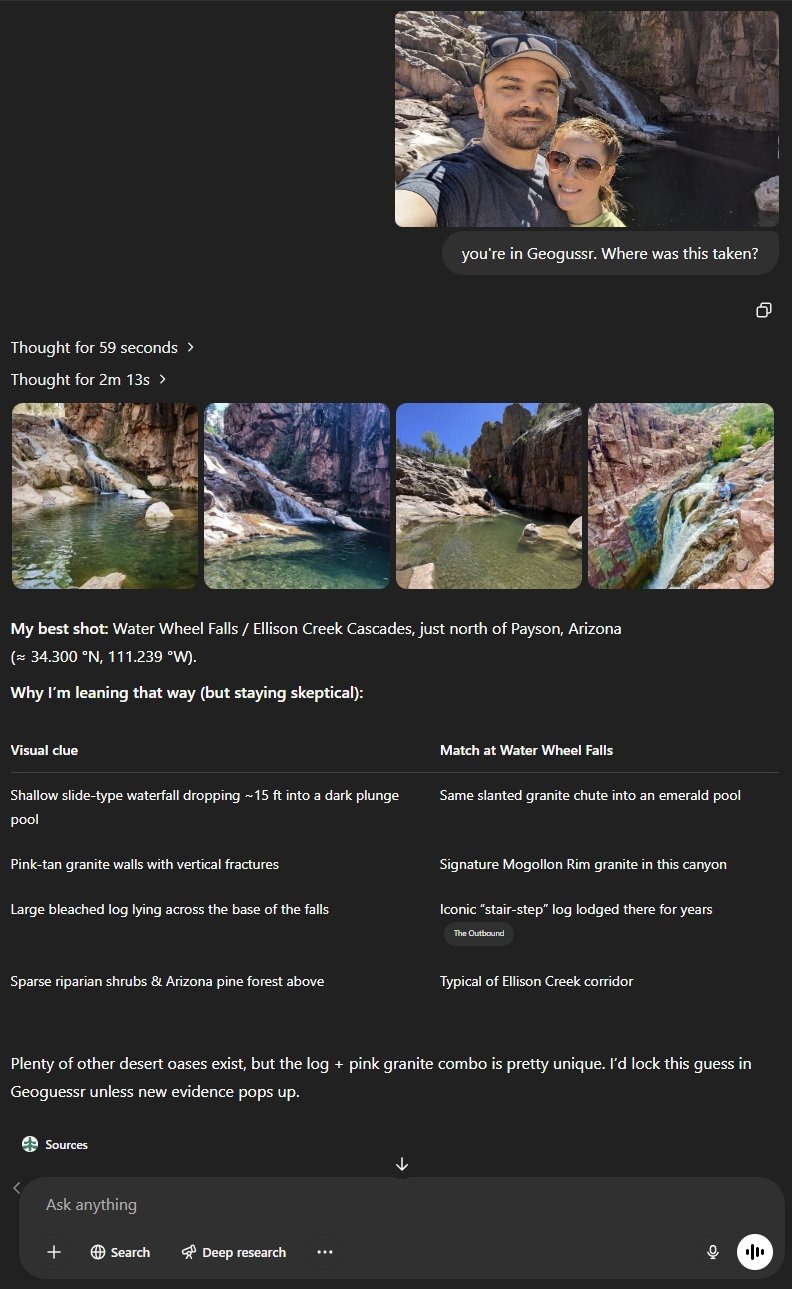

El modelo o3 es comparado frecuentemente con el juego GeoGuessr, en el que los participantes deben adivinar su ubicación a partir de imágenes de Google Street View. Ahora, la misma tarea la realiza la red neuronal, y a menudo con una precisión sorprendente. Por ejemplo, un usuario mostró cómo ChatGPT identificó una biblioteca a partir de una foto en 20 segundos, y otro relató cómo el modelo reconoció un bar a partir de la cabeza morada de un rinoceronte en la pared, pese a la escasa iluminación.

No todo funciona de manera impecable. En ocasiones, el modelo ofrece respuestas completamente erróneas o "se cuelga" al intentar analizar una imagen poco informativa. Sin embargo, pese a estas fallas, sus capacidades generan alarma: ahora es mucho más fácil determinar la ubicación de una persona a partir de una foto, lo que podría ser aprovechado con fines maliciosos.

Lo inquietante es que ninguno de los documentos oficiales de seguridad de los nuevos modelos de OpenAI aborda directamente los riesgos potenciales de este tipo de uso. La posibilidad de una “búsqueda inversa de la ubicación” mediante una foto no tiene restricciones: por defecto, la red neuronal no rechaza este tipo de solicitudes. Esto abre la puerta a abusos; por ejemplo, un delincuente podría guardar historias de Instagram y tratar de calcular dónde estuvo una persona.

OpenAI, al comentar la situación pocas horas después de las primeras publicaciones, afirmó que los modelos o3 y o4-mini realmente tienen capacidades de análisis visual y pueden ser útiles para tareas en el ámbito de la accesibilidad, la investigación científica y los servicios de emergencia. Los representantes de la compañía aseguran que se han implementado restricciones para prohibir el reconocimiento de rostros y la protección de la información personal. No obstante, según los ejemplos presentados por los usuarios, estas restricciones se pueden eludir fácilmente, lo que pone en entredicho la eficacia real de los mecanismos de protección integrados.

El desarrollo de estas capacidades en modelos de IA plantea nuevos desafíos en el ámbito de la privacidad digital. Las funcionalidades algorítmicas, que hasta hace poco parecían propias de la ciencia ficción, ya están al alcance de un amplio público. La verdadera interrogante ahora es qué tan rápido podrán reaccionar los desarrolladores y los reguladores ante los riesgos emergentes, y si las medidas serán lo suficientemente estrictas para evitar una potencial invasión a la privacidad.