80 años de video al día: el apetito del nuevo proyecto Cosmos de Nvidia

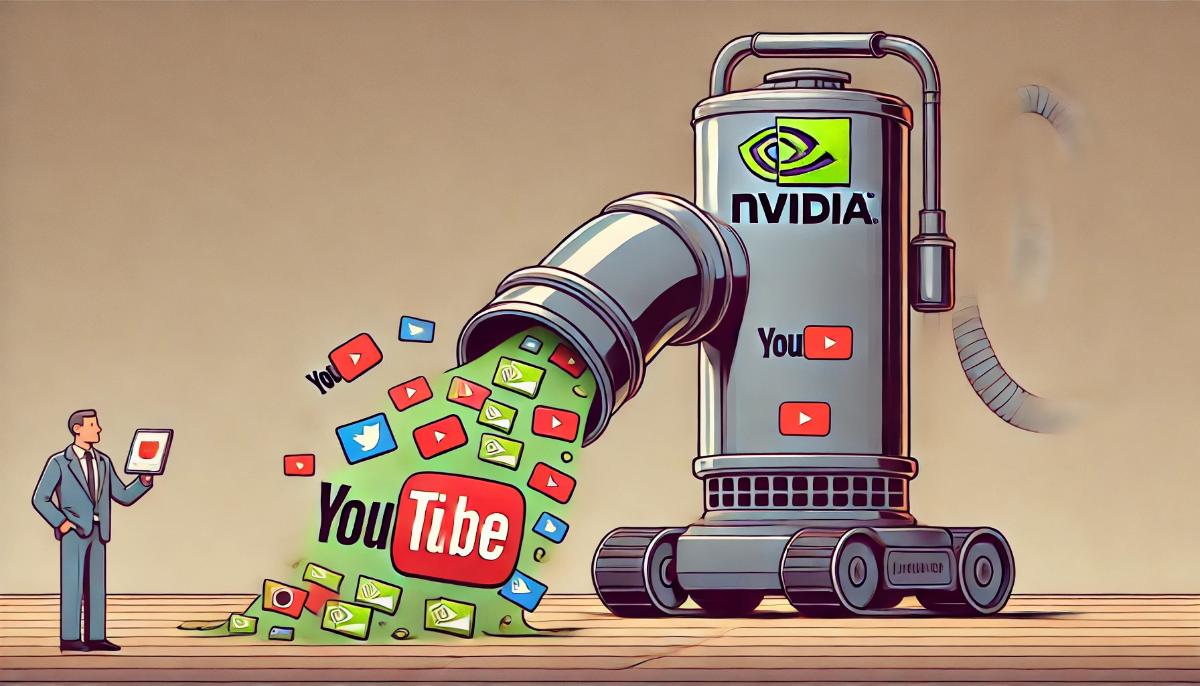

Nvidia recolectó millones de videos de YouTube en secreto para entrenar su IA.

Nvidia utilizó videos de YouTube y otras fuentes para entrenar sus productos de IA, según revelan comunicaciones internas y documentos obtenidos por 404 Media.

Al discutir los aspectos legales y éticos del uso de contenido protegido por derechos de autor para entrenar modelos de IA, Nvidia afirmó que sus acciones cumplen completamente con la ley de derechos de autor. Las conversaciones internas muestran que, cuando los empleados plantearon preocupaciones sobre posibles problemas legales, los gerentes los aseguraron que tenían permisos para usar los datos, otorgados por la alta dirección de la compañía.

Un ex empleado de Nvidia informó que se les pedía descargar videos de Netflix, YouTube y otras fuentes para entrenar modelos de IA, como el generador de mundos 3D Omniverse, sistemas para autos autónomos y productos con "personas digitales". El proyecto, denominado Cosmos, aún no se ha presentado al público.

El objetivo de Cosmos era crear un modelo moderno de generación de videos capaz de modelar luz, física e inteligencia en un solo lugar, lo que permitiría utilizar Cosmos en diversas aplicaciones. Los mensajes internos muestran que los empleados usaban el programa de código abierto yt-dlp para descargar videos de YouTube, evitando bloqueos a través de máquinas virtuales con direcciones IP actualizables.

Los gerentes del proyecto discutieron el uso de 20-30 máquinas virtuales en Amazon Web Services para descargar videos equivalentes a 80 años de visualización cada día. En mayo, un representante de Nvidia afirmó que la compañía estaba finalizando la primera versión de la línea de datos y preparándose para crear una fábrica de datos de video que "generará datos equivalentes a toda una vida humana cada día".

Un representante de Nvidia declaró que la compañía está segura de que sus modelos cumplen con la ley de derechos de autor, ya que la ley protege las expresiones, pero no los hechos, ideas, datos o información, que pueden utilizarse para crear sus propias expresiones.

Google y Netflix confirmaron que el empleo de su contenido por parte de Nvidia viola sus términos de uso. Los empleados de Nvidia, preocupados por los aspectos legales, recibieron la respuesta de los gerentes de que era una "decisión ejecutiva" y que no debían preocuparse por ello.

Sin embargo, muchos investigadores y abogados sostienen que el empleo de contenido protegido por derechos de autor para entrenar IA es una cuestión legal abierta. En los últimos años, los académicos han tendido a licenciar sus datos de investigación para uso no comercial, con el fin de limitar el uso comercial de su trabajo.

El proyecto Cosmos incluía el uso de videos tanto públicos como internos, así como datos recopilados por investigadores. Sin embargo, muchas de las licencias de estos conjuntos de datos limitan su uso exclusivamente a fines académicos.

En las discusiones dentro de Nvidia también surgió la cuestión del uso potencial de videos de películas para entrenar modelos. Los empleados propusieron cargar películas como "Avatar" y "El Señor de los Anillos" para obtener datos de alta calidad. Sin embargo, esto generó preocupaciones sobre posibles conflictos con Hollywood y otras partes interesadas.

El proyecto enfrentó varios problemas técnicos y legales relacionados con la captura de videos de juegos y otras fuentes. No obstante, en marzo, Nvidia logró descargar 100,000 videos en solo dos semanas, lo que fue un paso importante en la implementación del proyecto.

Es notable que el principal científico de Nvidia, Francesco Ferroni, creó un canal en Slack con el objetivo de crear un enorme conjunto de datos de video para el proyecto Cosmos. Ferroni añadió al canal un enlace a una tabla con una lista de conjuntos de datos, incluidos:

- MovieNet (una base de datos de más de 1,000 películas y 60,000 tráilers de películas);

- WebVid (un conjunto de datos de video en GitHub, compilado a partir de imágenes de stock y eliminado por su creador tras una solicitud de cese y desista de Shutterstock);

- InternVid-10M (un conjunto de datos que contiene 10 millones de ID de videos de YouTube);

- varios conjuntos de datos internos con cuadros guardados de videojuegos.

La situación del proyecto Cosmos demuestra cómo las grandes empresas tecnológicas utilizan zonas grises legales para acumular grandes volúmenes de datos necesarios para entrenar modelos de IA. Al mismo tiempo, esto pone en peligro los derechos de los creadores de contenido y genera preocupaciones entre investigadores y defensores de los derechos.

El escándalo también mostró que en la industria de la IA existe una cultura significativa de "no pedir permiso", lo que socava la confianza en la tecnología y plantea preguntas sobre la necesidad de una regulación más estricta. Hasta que se establezca un marco legal claro y estándares de transparencia, situaciones similares seguirán ocurriendo, poniendo en riesgo tanto los derechos de los autores de contenido como la confianza pública en las innovaciones en el campo de la inteligencia artificial.