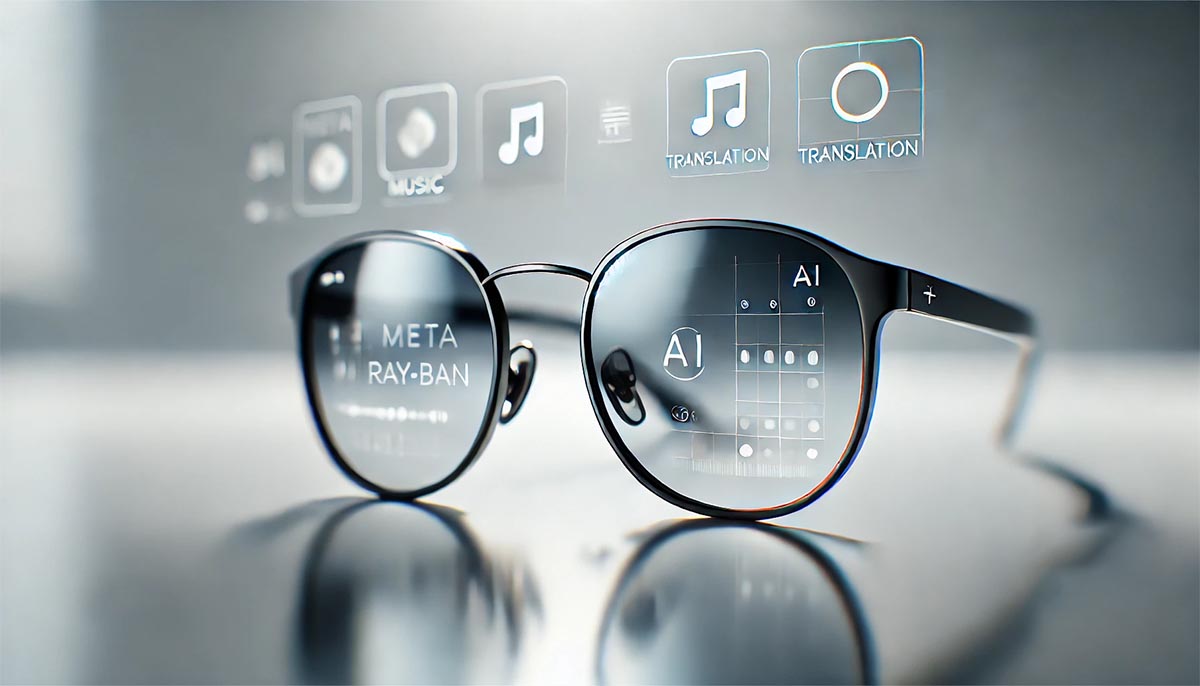

Ver, escuchar, comunicar: Meta aporta a las gafas Ray-Ban tres nuevas funciones

La innovadora actualización ofrece una nueva forma de interactuar con el mundo físico.

La compañía Meta presentó varias funciones nuevas para sus gafas inteligentes Ray-Ban: inteligencia artificial en vivo, traducciones instantáneas y soporte para Shazam. La IA en vivo permite interactuar con el asistente virtual de Meta en tiempo real mientras analiza el entorno. Por ejemplo, al estar en la sección de verduras de una tienda, se puede pedir a la IA sugerir recetas basadas en los productos seleccionados.

La función de traducción en vivo proporciona traducción simultánea de voz entre inglés, español, francés e italiano. Las traducciones se pueden escuchar a través de las gafas o ver las transcripciones en un teléfono inteligente. Sin embargo, se requiere una descarga previa de los paquetes de idiomas antes de usarlos.

El soporte de Shazam funciona de manera más sencilla: las gafas pueden reconocer la música que suena en su campo de visión. Basta con activar Meta AI e indicar la melodía reproducida. El propio Mark Zuckerberg demostró recientemente esta funcionalidad en un reel de Instagram.

Para usar las nuevas funciones, es necesario actualizar el firmware de las gafas a la versión v11 y la aplicación Meta View a la v196. La IA en vivo y las traducciones están disponibles solo para los participantes del programa de acceso temprano, mientras que Shazam puede ser utilizado por todos los usuarios en EE. UU. y Canadá.

El anuncio de Meta ocurre en un contexto de creciente interés de las grandes compañías tecnológicas en la inteligencia artificial para dispositivos portátiles. Recientemente, Google presentó el sistema operativo Android XR para gafas inteligentes e integró en ellas a su asistente de IA Gemini. Por su parte, el director técnico de Meta, Andrew Bosworth, señaló que 2024 ha sido un punto de inflexión para las gafas con inteligencia artificial, calificándolas como una nueva categoría de dispositivos completamente definida por la IA.