OpenAI: por favor, no se enamoren de ChatGPT-4o

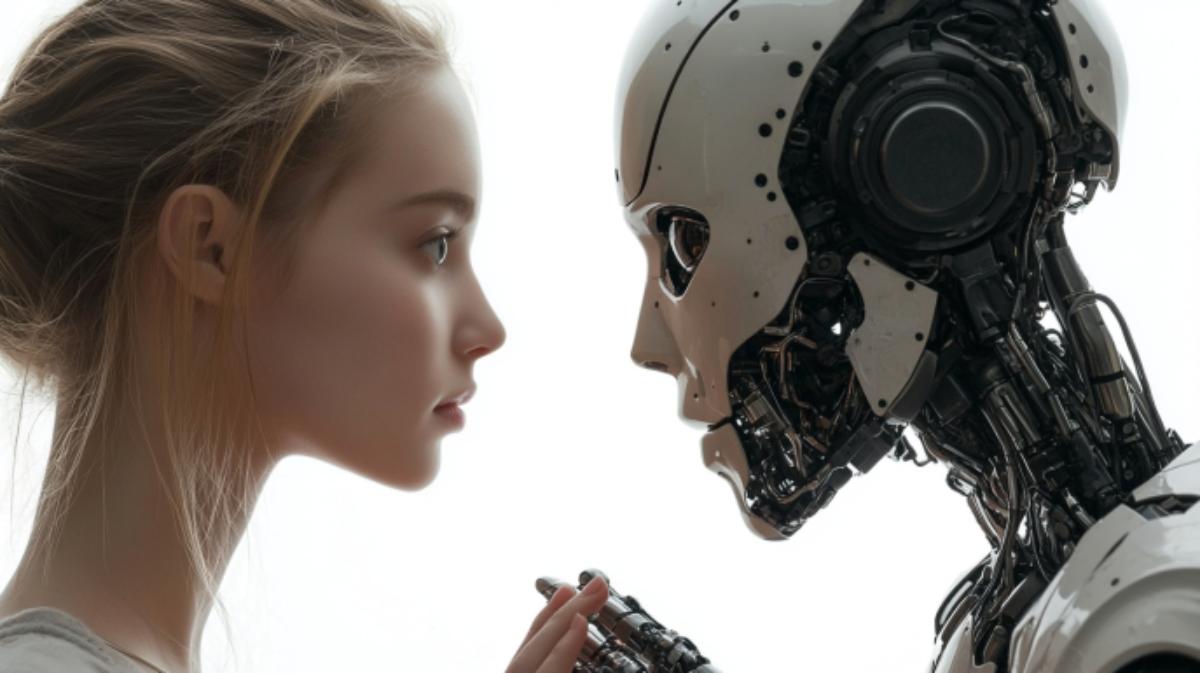

La inteligencia artificial se está volviendo demasiado humana.

OpenAI, la empresa creadora del popular chatbot ChatGPT, ha expresado su preocupación por el comportamiento inusual de los usuarios de la última versión de su producto, ChatGPT-4o. Los desarrolladores han notado que las personas están comenzando a formar un apego emocional con la inteligencia artificial, lo que podría ser peligroso desde el punto de vista psicológico.

ChatGPT-4o, la iteración más reciente en la línea de chatbots de OpenAI, se distingue por respuestas más rápidas y una nueva función de comunicación por voz que imita sorprendentemente bien el habla humana. En su esfuerzo por crear una experiencia de conversación lo más realista posible, los desarrolladores parecen haber pasado por alto el hecho de que las personas inconscientemente pueden empezar a percibir al interlocutor virtual como una persona. Ahora, la empresa enfrenta un desafío inesperado: cómo mantener el equilibrio entre el progreso tecnológico y la seguridad psicológica de las personas.

Durante las pruebas de la nueva versión del chatbot, los especialistas descubrieron que los usuarios comenzaron a utilizar expresiones que indican la formación de un vínculo emocional con el modelo. Por ejemplo, algunos se despedían del bot con frases como "Este es nuestro último día juntos".

En una declaración oficial, OpenAI señaló: "Aunque estos casos parecen inofensivos, indican que necesitamos estudiar más a fondo cómo este tipo de comunicación afecta a los usuarios a largo plazo. Es importante analizar cómo diferentes grupos de personas, con sus necesidades y expectativas únicas, interactúan con nuestro modelo. Investigaciones académicas independientes y nuestras observaciones internas ayudarán a identificar con mayor precisión los riesgos potenciales".

Por un lado, un interlocutor virtual puede ofrecer consuelo a personas solitarias. Por otro lado, esta tendencia podría afectar negativamente el desarrollo y mantenimiento de relaciones humanas saludables en el mundo real. Además, la interacción prolongada con el modelo está cambiando nuestras concepciones de las normas de comunicación. Por ejemplo, los chatbots permiten a los usuarios interrumpirlos y "tomar la iniciativa" en cualquier momento. En una conversación entre dos personas, esta no es la mejor estrategia. Por supuesto, las máquinas no se ofenden, no tienen la necesidad de compartir sus experiencias y sentimientos a menos que el interlocutor lo solicite. Además, el chatbot siempre está "de buen humor", lo que no es sorprendente, ya que la conversación con él fluye tan fácilmente.

Hay otro motivo de preocupación: los usuarios podrían dejar de evaluar críticamente la información que proporciona ChatGPT-4o. Antes, las personas trataban los errores y fantasías de la IA con desconfianza. Ahora, cuando el chatbot se parece tanto a una persona, sus palabras corren el riesgo de convertirse en la "verdad absoluta". Algunos comienzan a creer todo lo que dice el bot, sin considerar la verificación de los hechos.

Al darse cuenta de la magnitud del problema, OpenAI planea monitorear cuidadosamente cómo los usuarios interactúan con ChatGPT-4o y realizar los cambios necesarios en el sistema de manera oportuna. Es posible que más adelante se añada un recordatorio al sistema de que, a pesar de la realista interacción, estamos tratando con una máquina, no con una persona viva.